“Le

tecnologie sono un “dono di Dio” che “può portare frutti di

bene” ma che deve essere utilizzato correttamente se non vogliamo

che comporti “gravi rischi per le società democratiche”

[Papa Francesco]

Durante

il lockdown dello scorso anno mi misi a scrivere un articolo che non

ebbe mai la luce e che aveva come obiettivo di fare riflettere sul

fenomeno delle fake news che ho avuto l’ardire di associare alle

minacce cibernetiche più invasive degli ultimi anni.

Tratto da : rcmediafreedom.eu

Se nei vari rapporti relativi alle minacce cibernetiche si introducesse la voce “fake news”, sono sicuro che si otterrebbero dei numeri molto interessanti, probabilmente superiori a quelli del phishing, per fare un esempio, che rappresenta il vettore d’attacco più utilizzato in assoluto secondo l’ultimo rapporto Clusit.

Più o meno, l’articolo cominciava così:

Lavorando per un’azienda americana, il termine “storytelling” viene utilizzato in maniera estremamente frequente ormai da diverso tempo. Ciò che meraviglia, forse nemmeno troppo, è che pur avendo una lingua così bella e ricca di termini, è prassi comune e consolidata in Italia, a ogni livello, affidarsi a termini stranieri, il più delle volte inglesi. Devo dire, comunque, che c’é qualcosa di particolare in questa parola, qualcosa che non saprei descrivere ma che suscita una specie di meraviglia e stupore nel chi ascolta, non appena viene evocata. Basta utilizzarla per fare apparire impreziosito un ragionamento, valido o no che sia, ed ecco che come per magia, gli interlocutori si illuminano come se si fosse espresso il concetto più profondo di sempre.

Ormai è diventato di uso comune, tanto che non ci facciamo neanche più caso, tanto che, forse, abbiamo smesso di domandarci veramente cosa intendiamo quando parliamo di storytelling oppure sappiamo di cosa parliamo ma, con tutta probabilità, ce lo siamo dimenticato.

Durante l’emergenza del coronavirus il nostro ruolo è chiaro. Ci è stato raccomandato di “eseguire gli ordini” e di fare la nostra parte rispettando le regole come, del resto, dovrebbe avvenire sempre in un contesto democratico e di comunità. Le mie azioni non hanno impatto solo su me stesso ma anche sulle persone che mi circondano e con le quali interagisco e così, al contrario.

Eppure, durante questa esperienza mai vissuta prima, abbiamo un atteggiamento un po' asimmetrico rispetto a coloro che stanno cercando di affrontare e risolvere l’emergenza e non possiamo fare altro che obbedire e fidarci.

Ed ecco la parola chiave: fiducia. Guardiamo cosa ci dice la Treccani a proposito di questa parola così importante.

fidùcia s. f. [dal lat. fiducia, der. di fidĕre «fidare, confidare»] (pl., raro, -cie).

Atteggiamento, verso altri o verso sé stessi, che risulta da una valutazione positiva di fatti, circostanze, relazioni, per cui si confida nelle altrui o proprie possibilità, e che generalmente produce un sentimento di sicurezza e tranquillità: f. in Dio, negli uomini, nella fraternità umana, nella scienza, nel progresso sociale; f. nella vittoria; f. di riuscire; f. nella propria stella, nelle proprie forze; f. nell’esito di un’impresa; guardare con f. all’avvenire; ferma f.; f. illimitata, assoluta, incondizionata; avere, nutrire f.; perdere la f.; dare un attestato, una prova di f.; ispirare f.; guadagnare, meritare, godere, avere la f. di qualcuno; riporre bene, o male, la propria f.; abusare della f. altrui. Di uso com. le espressioni: persone di f., di mia, di tua, di sua f., persone fidate a cui si ricorre in cose delicate e d’importanza; medico, avvocato di f., quello che è liberamente e abitualmente scelto dal cliente; posto, impiego, incarico di f., di responsabilità, delicato, che si affida solo a persone sicure, fidate.

In diritto costituzionale, voto di f., votazione mediante la quale il parlamento approva (o, se la votazione dà risultato negativo, disapprova) gli indirizzi politici e la corrispondente azione del governo; mozione di f., la proposta, fatta da una delle Camere, di ricorrere al voto di fiducia; questione di f., richiesta da parte del governo di ricorrere al voto di fiducia per l’approvazione o la reiezione di emendamenti e articoli di progetti di legge: il governo ha deciso di porre la questione di fiducia.

In diritto civile, f. testamentaria (o disposizione testamentaria fiduciaria), disposizione di testamento per la quale il soggetto che riceve il bene ne è il beneficiario apparente, avendo l’obbligo di trasmettere quel bene ad altra persona (che normalmente non potrebbe essere erede diretto del testatore).

Fiducia è una parola “pesante” che abbraccia scenari ampi e che rappresenta una responsabilità importante in chi la dà e in chi la riceve.

Questo per dire che dobbiamo confidare in coloro che stanno cercando, con non poche difficoltà, di fare fronte ad un problema a cui nessuno era preparato. Pertanto, dobbiamo avere fiducia nelle istituzioni centrali, nelle amministrazioni locali, nei medici, negli scienziati e, non meno importante, in chi ci racconta ciò che succede, ovvero i giornalisti e i conduttori.

Fiducia... dobbiamo averla in maniera incondizionata, soprattutto considerando il mondo nel quale viviamo? Un mondo nel quale siamo bombardati quotidianamente da una quantità enorme di notizie che affermano tutto ed il contrario di tutto?

Ecco, forse, il punto fondamentale: la gestione della comunicazione.

Sia da parte delle istituzioni sia da parte dei media, soprattutto all’inizio della pandemia, la modalità con cui si è comunicato ha provocato una fuga di notizie che ha generato profonde discussioni ma anche reazioni irrazionali verso tutto e tutti, a partire dal famoso episodio relativo a coloro che affollarono le stazioni del nord per scappare al sud tanto che, col passare dei giorni ci siamo resi conto che quella reazione così irrazionale è stata pur sempre innescata da un gesto altrettanto irresponsabile.

Sembrava, perciò, esserci stata l’occasione per riflettere sul modo in cui, in parallelo agli sforzi medici, si dovesse e potesse affrontare il coronavirus sul piano della comunicazione, ragionando appunto su uno storytelling dell’emergenza.

Invece, la narrazione della crisi è proseguita su binari che facevano affidamento su termini, pratiche e abitudini che, purtroppo, caratterizzano in negativo la comunicazione da tempo, ben prima della diffusione del Covid-19.

Il sensazionalismo, l’analisi grossolana, la ricerca frettolosa di buoni e cattivi, di eroi e di nemici della patria. In un momento in cui gli italiani non possono far altro che fidarsi di ciò che viene loro detto, la confusione e la disinformazione hanno dilagato tanto quanto il virus, rendendo sempre più difficile la comunicazione e, di fatto, quasi vanificando l’occasione di proporre finalmente una narrazione di qualità, mai come ora di vitale importanza.

E tutto ciò perché oggi come oggi la lettura, l’approfondimento, la ricerca della veridicità delle notizie è privilegio di pochi mentre la maggioranza delle persone ascolta gli imbonitori politici e i giornalisti di parte che pur di raccattare voti, da un lato, e influenzare l’opinione pubblica dall’altro, anche in una situazione così critica come questa, usa la comunicazione in modo fazioso e strumentale.

Tutto ciò, lo vogliate o no, rientra nella categoria delle fake news.

“Fake” o fake news” continuano ad essere termini che non rendono giustizia all’ampiezza del fenomeno che stiamo vivendo perché sarebbe più corretto parlare di manipolazione o di disinformazione che non sono, senza dubbio, concetti nuovi ma che, rispetto al passato, si arricchiscono di ulteriori implicazioni.

Appurato che, ormai, la maggior parte della popolazione preferisce apprendere qualsiasi tipo di informazione dai “social”, indipendentemente dall’importanza dell’argomento, è possibile affermare che tra i principali rischi vi sia quello che possano essere ritenute valide informazioni palesemente false.

Questa situazione è ulteriormente ingigantita dal cosiddetto “backfire effect” ossia il fenomeno secondo il quale “quando si contesta un’informazione falsa ma già consolidata, si finisce col confermarla ancor di più perché, purtroppo, si è restii a cambiare la propria opinione”.

Possiamo affermare che tutti i settori culturali della società contemporanea sono vittime delle “fake news” anche se la concentrazione maggiore risulta essere sui contenuti di carattere scientifico.

Il punto di vista personale è che la disinformazione in questo settore trova terreno fertile nel propagarsi perché si basa principalmente sull’ignoranza dei concetti di base.

Il fatto che il linguaggio scientifico sia estremamente specifico permette a coloro che creano disinformazione di ottenere un immediato e notevole successo incidendo negativamente sul mondo accademico che rischia di perdere di credibilità. È emblematico anche il fatto che quando subentrano falsità che riguardano la salute, il danno provocato rischia di diventare irreparabile.

Sono stati svolti molti studi al riguardo e ciò che emerge è che esiste la convinzione da parte di molti nel definire centrale il ruolo delle “tech companies”, le società tecnologiche che, lungi dal funzionare come semplici “piattaforme” svolgono un ruolo più in linea con le caratteristiche e i requisiti delle aziende.

Il grande potere di queste società non si esaurisce nel caricare contenuti su una piattaforma ma, al contrario, si innalza grazie al controllo in maniera selettiva e puntuale di ciò che noi vediamo dal momento che è proprio questo il loro modello di business.

E l’obiettivo finale, come per la politica, del resto, rimane quello di aumentare il loro pubblico di utenti, “lisciandogli il pelo, per usare un eufemismo un po' “francese” 😊, modificando il flusso delle informazioni a dispetto della loro presunta neutralità.

A tal fine fanno largo uso di algoritmi sofisticati, analisi di dati, tecniche di data matching e profiling grazie ai quali viene processata una grande mole di informazioni raccolte, concesse a terzi senza, molto spesso il consenso degli interessati oppure con un consenso inconsapevole; dati che vengono utilizzati, contestualmente alla raccolta, nella promozione pubblicitaria e nel micro targeting attraverso i social media.

I bot sono un altro strumento utilizzato in modo notevole. Si tratta, come sappiamo, di programmi che accedono alla rete attraverso lo stesso tipo di canali utilizzati dagli utenti umani e che consentono, tra le altre cose, attraverso specifici algoritmi, di realizzare compiti precisi come le attività di data scraping e Web scraping che danno luogo all’estrazione di dati e informazioni presenti in una determinata pagina per usarle in altri contesti.

Nella piazza virtuale le informazioni false o scorrette, siano esse di natura commerciale oppure politica, sono occultate, inviate a un micro target di persone sulla base di dati raccolti da potenti società di web marketing, senza che gli interessati ne siano a conoscenza.

Sempre più spesso il “dibattito pubblico”, incentrato su temi di grande complessità e di difficile soluzione, che riguardano il futuro di tutti, viene stravolto e trasformato in vere e proprie campagne di marketing del consenso, fatte di soli slogan che riempiono lo spazio pubblico.

In buona sostanza, le tech companies sono stimolate, anche dal punto di vista economico, a dare la priorità ai contenuti sensazionali dal momento che sono maggiormente suscettibili nell’attirare l’attenzione oltre che nel favorire la polarizzazione e la radicalizzazione dei dibattiti.

La sensazione dilagante è che la disinformazione che circola sulle piattaforme sia frutto di un progetto organizzato e condotto da attori che hanno compreso benissimo alcuni principi basilari dell’economia digitale attraverso i quali ottenere ingenti introiti pubblicitari.

Tutto ciò ha continuato a dilagare in modo incontrollato cosicché, nell’ottobre 2018, le principali piattaforme digitali hanno sottoscritto un “codice di condotta” per combattere la disinformazione online. Si tratta di un inizio ma che rappresenta una tappa fondamentale nella lotta ad un problema che potenzialmente è in grado di minacciare la fiducia dei cittadini verso le istituzioni, come ribadito in ambito UE.

L’obiettivo dell’Unione Europea, tra le altre cose, è quello di gestire un pacchetto di norme di autoregolamentazione su base volontaria, idonee a contrastare la disinformazione del web.

Di fatto, con l’adesione a questo progetto, ogni impresa del web si è data delle regole per combattere la disinformazione in tutti gli Stati membri dell’Ue.

Da tutto ciò si evince che l’informazione si è trasformata in “comunicazione” e che, al contempo, si è sviluppata la disinformazione, che rappresenta senza dubbio un fenomeno complesso e in trasformazione, e che può essere usato come una nuova arma, per finalità di tipo politico, economico o militare.

Oggigiorno sono tantissime e raffinatissime le tecniche di disinformazione tanto da rappresentare una minaccia per la sicurezza e la stabilità di un paese. Per questo, come anticipato, ho l’ardire che possiamo considerarle come una minaccia cyber.

Non è un caso, infatti, che quando si mettono in discussione l’integrità e la stabilità di un Paese si fa ricorso ai servizi di intelligence che giocano un ruolo fondamentale nel contrasto a tali forme di minaccia. Gli stessi servizi di intelligence peraltro sono stati interessati ad una trasformazione che li ha portati ad assumere una connotazione in grado di affrontare le nuove sfide alla sicurezza.

Senza entrare nel dettaglio di cosa si intenda per intelligence e consapevole che il lettore possa, comunque, apprenderlo da diverse fonti (https://www.sicurezzanazionale.gov.it/sisr.nsf/cosa-facciamo/l-intelligence.html), proprio perché occorre confrontarsi con nuove minacce ibride e, soprattutto, asimmetriche, il suo ruolo diventa fondamentale.

L’Intelligence è strettamente legata a ciò che avviene in ambito internazionale, soprattutto in merito ai rapporti di forza tra gli Stati ma anche al mercato globale.

Questo legame è ancora più vero se pensiamo a quelle aree del mondo dove non sono presenti conflitti di natura tradizionale ma che soffrono dei fenomeni di vulnerabilità originati da conflitti economici, forme avanzate di terrorismo di varia matrice ed attacchi attuati con metodologie nuove che, necessitano di forme di intelligence specifiche.

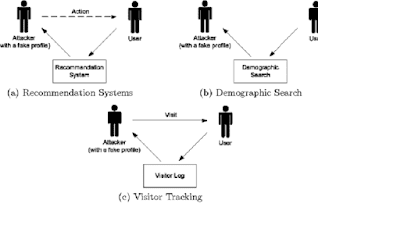

Le tradizionali “minacce alla sicurezza” si sono evolute per arrivare a più complesse minacce cibernetiche operate da attori che, fondamentalmente, possono essere distinti in due macro-gruppi:

attori governativi che sono molto strutturati ed estremamente pericolosi in virtù del fatto che dispongono di ingenti risorse economiche ed umane. Possiamo rappresentare le minacce di cui sono autori in due classi: cyber warfare che è una sorta di guerra digitale e cyber espionage che rappresenta lo spionaggio digitale.

attori non governativi di cui fanno parte i gruppi terroristici (cyber terrorism), le organizzazioni criminali (cyber crime) ed altri attori riconducibili ad individui mossi da impulsi religiosi, politici e ideologici.

Tutto ciò porta a pensare che sempre più spesso le azioni criminali faranno uso di strumenti tecnologicamente avanzati quali l’intelligenza artificiale il cui fine sarà quello di destabilizzare i rapporti internazionali ed avere una percezione della sicurezza, per così dire, indotta.

Una possibile arma è quella del “deepfake”, basata su processi che sfruttano i principi dell’intelligenza artificiale per modificare e sovrapporre immagini e video partendo dagli originali così da elaborarne altri in cui i soggetti compiono azioni, parlano e si muovono in contesti assolutamente non reali, grazie a tecniche di machine learning quali “generative adversarial network”.

Ci sono poi i “fake people”, persone che non esistono nella realtà ma che sono i protagonisti di video virtuali che generano sentimenti forti quali rabbia, sfiducia, compassione, paura o disagio in funzione delle finalità che si perseguono.

Lo sviluppo di una cyber intelligence efficace è una realtà incontrovertibile che deve adeguarsi ai mutati scenari basandosi sull’analisi di fonti aperte, sull’elaborazione dei big data, sullo sviluppo di tecniche di intelligenza artificiale con le quali far fronte alla cyber warfare e garantire la difesa della collettività.

Da qui, risulta evidente il legame con quanto questo articolo ha avuto la pretesa di evidenziare e cioè: “notizia”, “informazione”, “disinformazione” entrano e si permeano all’interno del sistema “media” e del sistema “intelligence” e per evitare che le tecnologie così pervasive possano far “esplodere” il sistema di comunicazione e di informazione con ripercussioni inimmaginabili sulla stessa società, è fondamentale che l’intelligence assuma un ruolo centrale per garantire la sicurezza.

In sintesi, ci troviamo di fronte ad un sistema estremamente complesso all’interno del quale risulta quasi impossibile stabilire quale sia la fonte di una notizia o verificarne la veridicità. Questo perché chi genera fake news tende a mettere sullo stesso piano qualsiasi opinione o parere in merito ad un dato argomento con il risultato che tutti si sentano dei massimi esperti ☹. Fatto, peraltro, estremamente amplificato dai social. Il dramma è che di fronte a tutto questo la maggioranza degli utenti è impotente anche e soprattutto in virtù del fatto che, ormai, accettano qualsiasi notizia venga loro fornita da giornali, tv o social.

Sembra esistere una tetra similitudine tra i tempi in cui la censura, indipendentemente dal potere politico del Paese nella quale operava, si preoccupava di bloccare le informazioni e il tempo attuale in cui altri organi di potere setacciano, valutano, modificano e costruiscono una grandissima quantità di informazioni inutili ed irrilevanti confondendo e manipolando il destinatario di queste informazioni, ossia l’utente medio, ahimè incapace di opporre resistenza.

Credo sia fondamentale, a questo punto, investire su una moderna ed efficace cyber intelligence in grado di sviluppare capacità di cyber counter intelligence che vada oltre il mero ruolo difensivo e che sia, al contrario, molto più proattiva e finalizzata a potere operare nella dimensione cyber anche con attacchi e simulazioni, il cui scopo possa essere quello di ostacolare gli avversari che via via si materializzano in questo scenario.

Da ultimo ma non per questo meno importante e non ci stancheremo mai di sottolinearlo, bisogna investire su una formazione di tutti gli utenti verso una crescente sensibilità della sicurezza informatica affinché i rischi sempre maggiori e sempre più complessi possano essere rilevati, analizzati ed affrontati.

Carlo Mauceli

Per approfondire:

Proteggere i diritti umani nell'era della guerra ciberneticaPrima Pagina | Prima Pagina

Web e disinformazione: il ruolo dell’intelligence (diricto.it)

Fake news: la nuova era della guerra cibernetica | Trizio Consulting

Che cos'è il backfire effect, che non ci fa cambiare le nostre convinzioni errate - Wired

Rete generativa avversaria - Wikipedia

Fake people, cosa sono e perché vanno tenute d'occhio | Il Bo Live UniPD